Large Language Models: Ein Überblick

Große Sprachmodelle (Large Language Models, LLMs) sind KI-Systeme, die in der Lage sind, menschliche Sprache zu verstehen und zu generieren. Doch wie funktionieren LLMs, die schon jetzt unseren Alltag wie keine Technologie zuvor verändert haben?

Large Language Models

Large Language Model (LLM), dt. großes Sprachmodell, ist die Bezeichnung für Sprachsysteme künstlicher Intelligenz. Es handelt sich um Systeme, die mit umfangreichen Textdaten trainiert werden, z. B. mit Texten aus dem Internet, aus Büchern, Artikeln oder anderen Quellen. Sie sind darauf ausgelegt, Texte so zu verstehen, zu generieren und zu übersetzen, wie es der menschlichen Sprachfähigkeit entspricht. Große Sprachmodelle, wie GPT-4, Claude und Gemini, können kohärente Texte auf Grundlage eines Prompts (Eingabeaufforderung) produzieren.

Die Anwendungsbereiche von Sprachmodellen variieren. Sie werden für Übersetzungen, zur Textanalyse, Textgenese, andere Textarbeit, aber auch im Dienstleistungssektor, z. B. Kundenbetreuung oder für Planungstätigkeiten etc. eingesetzt. Mittlerweile sind Sprachmodelle auch in Computersoftware und mobile Endgeräte integriert, was sie zu alltäglichen Begleitern macht.

Das Level, auf dem LMMs heute operieren, ist Resultat verschiedener technologischer Entwicklungsschritte. Frühe Modelle wie N-Gramm-Modelle stützten sich auf statistische Methoden. Erst mit der Weiterentwicklung kamen neuronale Netze – sogenannte RNNs (Recurrent Neural Networks) und später dann auch Transformermodelle wie GPT (Generative Pretrained Transformer) und BERT (Bidirectional Encoder Representations from Transformers) auf den Markt. Der Schwerpunkt dieser Modelle liegt nicht ausschließlich auf statistischen Methoden, sondern auf dem Verstehen des Kontextes und dem Generieren kohärenter Texte.

Sogenannte Transformermodelle verfügen über „Aufmerksamkeitsmechanismen“ [1], um verschiedene Bedeutungen von Wörtern abwägen und ihren Kontext einbeziehen zu können. Demnach kann GPT-3 mit 175 Milliarden Parametern einen "menschenähnlichen" (natürlichsprachlichen) Text erzeugen.

Um einen Leistungsüberblick verschiedener Sprachmodelle zu erfassen, wurden Benchmarks (Leistungstests) entwickelt. Die Modelle werden – nachdem sie trainiert wurden – an Benchmarks getestet und auf der Grundlage ihrer Genauigkeit und der Kohärenz des Outputs bewertet. Benchmarks wie GLUE (General Language Understanding Evaluation) und SuperGLUE bewerten die Sprachverständnisfähigkeiten dieser Modelle.

Dem gegenwärtigen Stand großer Sprachmodelle gehen langjährige Forschungsprozesse voraus, bei denen unterschiedliche Modelle mit eigenen Funktionsweisen entwickelt wurden. Im Folgenden werden die relevantesten aufgezählt:

N-Gramm-Modell

Das N-Gramm-Modell ist ein statistisches Modell zur Vorhersage des nächsten Elements in einer Sequenz, z. B. eines Worts in einem Satz. Dieser Prozess geschieht auf Grundlage der Formel „N-1“. Bei einem Bigram-Modell (2-Gramm-Modell) wird etwa das nächste Wort auf Grundlage des vorherigen Worts vorhergesagt.

FNN Modell

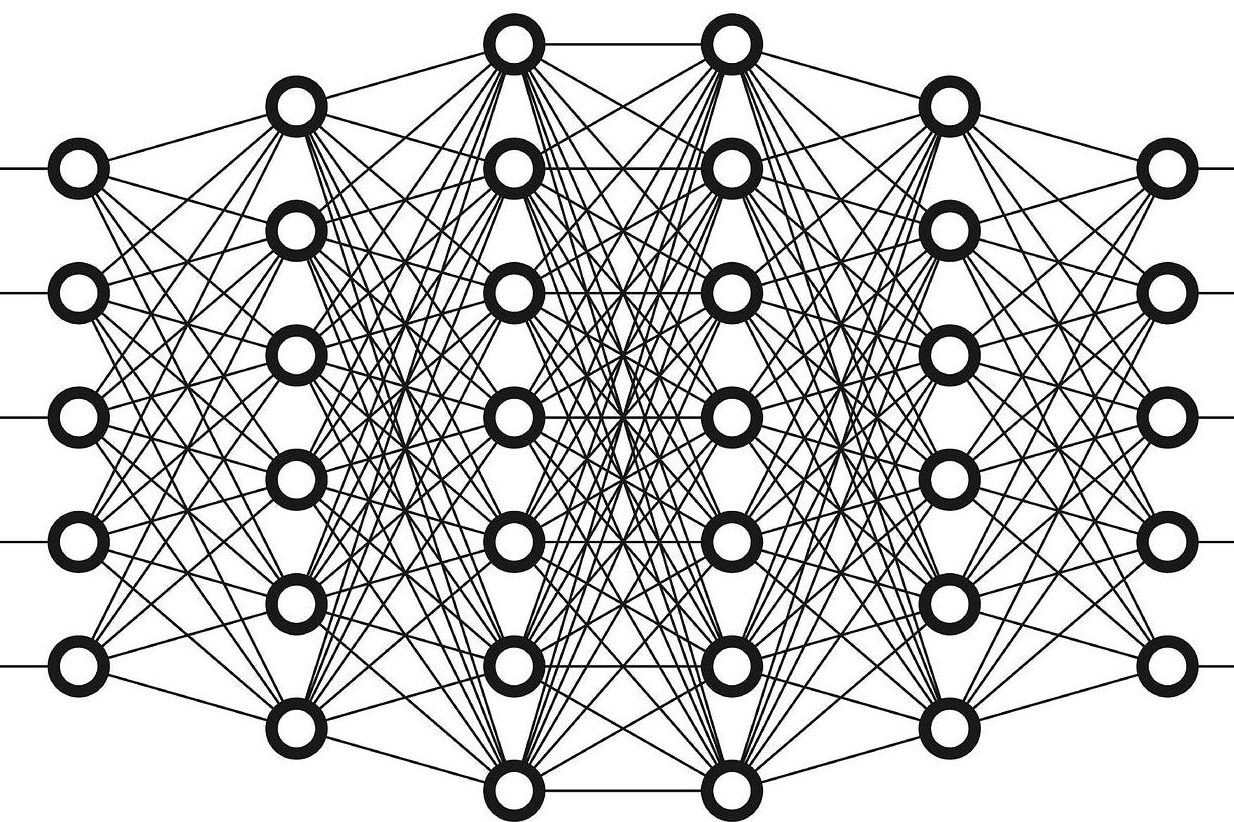

Ein Feedforward Neural Network ist ein neuronales Netz, bei dem die Verbindungen zwischen den Knoten (Neuronen) keinen Zyklus bilden. Das bedeutet, dass sich die Daten nur in eine Richtung bewegen – von den Eingangsknoten über die versteckten Knoten (falls vorhanden) bis zu den Ausgangsknoten – einem Fließband gleich.

RNN Modell

Ein Recurrent Neural Networks (RNN) ist ein neuronales Netz, das Muster in Datensequenzen, wie Text, Handschrift oder gesprochene Worte, erkennen kann. Im Gegensatz zu herkömmlichen neuronalen Netzen, die Eingaben unabhängig voneinander verarbeiten, haben RNNs Verbindungen, die einen Zyklus bilden, sodass sie ein "Gedächtnis" (Speicherbewusstsein) für frühere Eingaben in der Sequenz behalten. Dank dieses Speichermechanismus’ kann das neuronale Netz Entscheidungen auf der Grundlage langfristiger Abhängigkeiten in der Sequenz treffen.

Transformer

Transformer sind die (nach aktuellem Stand des Beitrags) modernste neuronale Netzwerkarchitektur. Im Gegensatz zu früheren Modellen können Transformer eine ganze Folge von Wörtern auf einmal betrachten. Dadurch können sie den Kontext und die Beziehungen zwischen den Wörtern besser verstehen. Sie verwenden „Self-Attention Mechanisms“ [2], die es ermöglichen, die Bedeutung verschiedener Wörter in einem Satz unabhängig von ihrem Abstand zueinander zu gewichten.

Einzelnachweise

1 Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, Illia Polosukhin: Attention is all you need. In: Advances in Neural Information Processing Systems (2017). S. 5998–6008.

2 Ebenda.

Autor:innen:

Text: Manuel Hettler

Lektorat: Jenifer Becker

Zitation

Manuel Hettler: Large Language Models: Ein Überblick. In: AI-Labkit https://ai-labkit.de/lernen/?post=large-language-models-ein-%C3%9Cberblick